Google DomainsがSquarespaceに事業譲渡されるアナウンスがありました。

https://support.google.com/domains/answer/13689670?sjid=4934868726297743719-AP

想定する移行先の年間料金

TLD .bizの場合

Cloudflare Registrar $13.68

Google domains $15

Route53 19.00 USD

さくらインターネット 3,340円 = $23.55 ※1$ = ¥141.84で換算

上記で一番安価なCloudflare RegistrarにGoogle DomainsでホストしているドメインをTransferしてみました。

https://www.cloudflare.com/products/registrar/

移管元で、Privacy、Transfer lockしている場合は解除しておく。

移管手続きの流れ

Cloudflare accountを作成

(https://dash.cloudflare.com/sign-up)

cloudflareのBillingでPayment info情報を登録

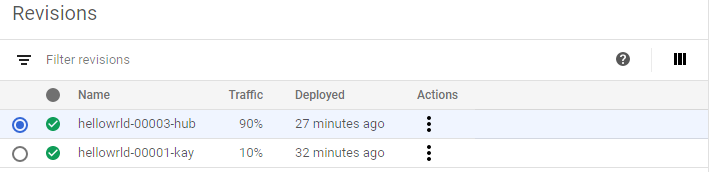

Websitesの作成

移行元のホストゾーンに登録している情報をCloudflareのDNS Recordsに追加してくれる

Cloudflare Nameservers情報を移行元のNSに追加

Cloudflare Namerserversが認識されたら、移行元のNS情報を削除

(反映されるまで数時間かかる。)

下記表題のStatus Activeになった旨のメールが届く

[Cloudflare]: xxxxxx is now active on a Cloudflare Free plan

Domain Registration のTransfer Domainsから移行手続きがおこなえるようになります。

移行元で取得しておいたauthorization codeをいれる

Transfer request受け付けたメールが届く

Your transfer to Cloudflare Registrar is underway

Google Domains からの移管リクエストを確認する

移行元(この場合、Google Domains)から移管リクエストを承認するメールが届くので下記表題のメール文中に記載されている移管をキャンセルまたは承認リンクで承認する

承認したあとでCloudflareから購入がクレジットカードからチャージされた旨のメールが届く。

Your Cloudflare Purchase Confirmation

Transfer完了のメールが届き、移管完了となります。

Your transfer to Cloudflare Registrar has completed!

所感

defaultでWHOIS privacyに対応している。

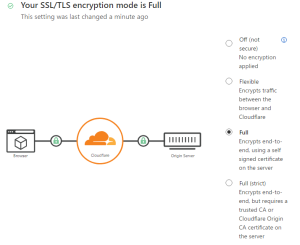

Proxiedというモードだと、originのIPアドレスを隠蔽するが、wp-login.phpでTOO MANY REDIRECTとリダイレクトループでエラーになってしまっているので、現状DNSに戻しています。

こちらの設定をすることで解消。

https://developers.cloudflare.com/ssl/troubleshooting/too-many-redirects/

What is the difference between “Proxied” and “DNS Only”?

https://community.cloudflare.com/t/what-is-the-difference-between-proxied-and-dns-only/173310

Cloudflare REgistrar and WHOIS privacy

https://community.cloudflare.com/t/cloudflare-registrar-and-whois-privacy/36225

Request Cloudflair Registrar To Support .Dev Domain

https://community.cloudflare.com/t/request-cloudflair-registrar-to-support-dev-domain/330897