3月6日「CloudStack Day 2014」、3月7日「第16回CloudStackユーザ会」に参加しました。CloudStack基盤を利用して、サービスを行っている事業者も、IDCフロンティア、Cloudnなどもあります。

VirtualBox 仮想アプライアンス環境「DevCloud2」を使って、CloudStack環境を構築することで、実際作業した内容になります。

まずは、http://people.apache.org/~bhaisaab/cloudstack/devcloud/devcloud2.ova からDevCloud2仮想アプライアスをダウンロードします。

次に、DevCloud2仮想アプライアンスをVirtualBoxインポートします。

ホストオンリーアダプタ追加

DHCPサーバー

サーバー有効化 チェックをはずす

DevCloud2にプリインストールされているJavaが6なので、そのままCloudStackをビルドすると、エラーになりますので、Java7を最初にインストールします。DevCloud2はベースは、Debianを利用しています。

システムアップデート

apt-get update

make-jpkgを利用可能にするのはjava-packageをインストール。

apt-get install java-package

make-jpkgは、rootでは弾かれるので、一般ユーザを作成して実行

make-jpkg jdk-7u51-linux-i586.tar.gz

debファイルをインストール

dpkg -i oracle-j2sdk1.7_1.7.0+update51_i386.deb

Java7をデフォルトにします。

update-alternatives –config java

ここまでで、CloudStackビルドの準備は終わりです。

git リポジトリからcloudstackをクローン

git clone https://git-wip-us.apache.org/repos/asf/cloudstack.git

最新版は4.4 (?)だと、マイ環境では「Imort Error:No module named codes」で後述の基本ゾーン作成で失敗しました。

今回は、4.2-forwardのrevisionを利用しました。

git checkout -b 4.2 origin/4.2-forward

ビルドを実行。しばらく時間がかかります。

mvn -P developer,systemvm clean install

デプロイ

mvn -P developer -pl developer,tools/devcloud -Ddeploydb

java heap sizeとかの設定を行わないと、cloudstackが起動できないので、java heap sizeの設定を行います。

export MAVEN_OPTS="-XX:+CMSClassUnloadingEnabled -XX:PermSize=256M -XX:MaxPermSize=512M -Xms512m -Xmx1024m"

cloudstackを起動します。

mvn -pl :cloud-client-ui jetty:run

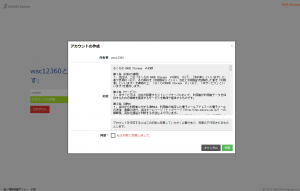

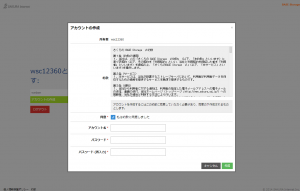

管理サーバーへログインまで確認

http://192.168.10.56:8080/client/

別コンソールを開いて、必要なパッケージの導入

pip install mysql-connector-python

pip install requests

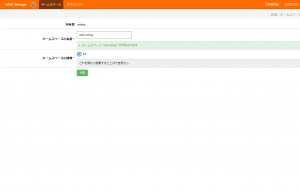

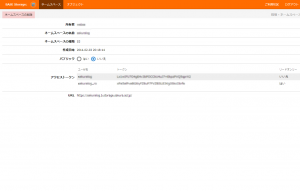

基本ゾーンの設定

mvn -P developer -pl tools/devcloud -Ddeploysvr

初期設定までは行うことができました。