昨日GCPUG信州の機械学習がテーマの勉強会に参加してきました。

Google Cloud Platform概要

- Googleのデータセンターの電力管理も、GoogleDeepMindにて、40%の削減

- Googleのサーバーはリソース状況により、どのサービスに使われるか変わる

- Googleのデータセンターの使用効率も80%

- 1Pbpsのネットワーク

- Region とZone。現在5つ。日本リージョンも近々?

- AppEngineの起動は速い。Go言語だと40s位

- インスタンス使用時間により、自動割引。同じマシンタイプを合算して割り引きしてくれる

- Preemtible VMs Borgのプライオリティの低いサービスを利用

- GCEのインスタンス課金は10分単位。10~20分程度の利用時間だと、1H課金のクラウドに比べ、単純に計算するだけでも、コストは1/2

Speech API

- 文脈認識率は8割。Cortana、WindowsAPIはせいぜい3~4割※単語レベルは高いが。

- US方言も。ただ、日本語の方言は対応していない

- しゃべり言葉はあまりよくない?

- Cloud Natural language API

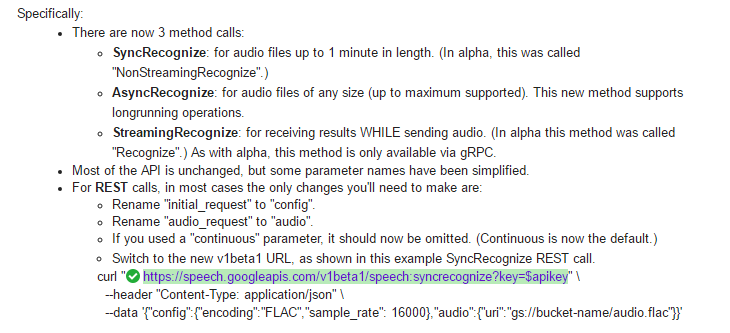

Speech API、βリリースにあたり、長い時間の音声ファイルの認識に使えるAsyncRecognizeの新機能が。gRPCプロトコルを使用している

TensorFlow

- PythonAPI、C++ APIが提供されているが、Python APIを使うのがよさそう

- 並列分散処理を簡単に実装できる。

- アルゴリズムを実装する道具、位置づけ

- APIも豊富 https://www.tensorflow.org/versions/r0.9/api_docs/python/index.html

- TensorFlow独自のプロセッサーを作成していた(TPU)。AlphaGoも使用されていた。

- ただ、GCEには、GPUインスタンスがない。GPUはCloud Machine Learningでは使えるとのこと。現在Limit Preview

CloudVisionAPIをIoTに

- プライバシー保護が重要。人の顔にマスク(モザイク)を掛ける

- APIベースなので、リソースが限られたRaspberryPiとかに有益

Docker

- コンテナの粒度はアプリ単位

- SwarmがDocker Engineに統合されたので、kubernatesとの使い分けはどうするか。今は過渡期

GCEをTensorFlow計算エンジン

- パーセプトロン

- バックプロパゲーション

- 畳み込みCNN。画像認識に使われている

- 過去にもネオコグニトロンと同等の機能があったが、ネットワークの性能、CPUパワーとかが当時に比べて向上したことで、DeepLearningが進化

- gcloud config-ssh ssh configurationに、インスタンスのaliasを登録してくれる。ssh <instance>.<region>.<project>でアクセスが可能に。Ansibleで複数インスタンスで学習自動化するのに役に立つ

CloudVisionAPI、Speech API、バックでは、DeepLearning技術は使われているので、Googleの基盤を少しわかった気がします。